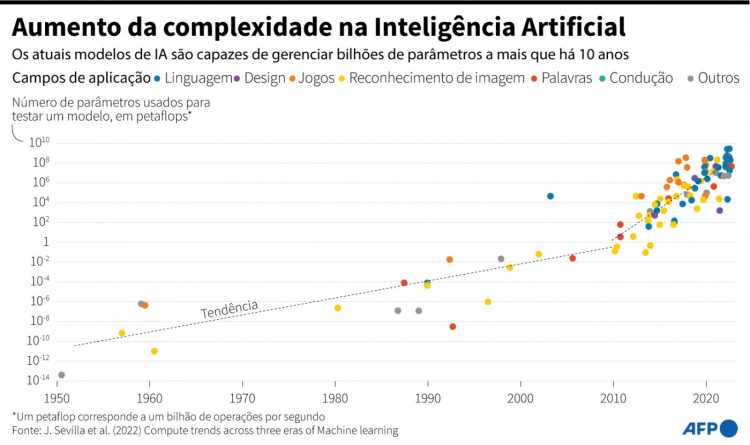

ChatGPT gerou um alerta mundial sobre a massificação e fácil acesso à inteligência artificial

Um alerta dado pelos cientistas no começo do mês de abril chamou atenção mundial para os riscos que o desenvolvimento da Inteligência Artificial (IA) pode gerar para a humanidade. “A sociedade fez uma pausa em outras tecnologias com efeitos potencialmente catastróficos. Nós podemos fazer aqui (com o GPT-4). Vamos tirar umas férias da IA e não vamos nos apressar e ficar despreparados”, diz a carta aberta, publicada pelo Future of Life Institute, órgão sem fins lucrativos. Na sequência deste comunicado, a Itália proibiu o uso do ChatGPT em seu território, alegando que o chatbot não respeita a legislação sobre dados pessoais e carece de um sistema de verificação da idade dos usuários menores. Segundo a autoridade italiana, o ChatGPT, lançado no final de novembro de 2022, sofreu, em 20 de março, uma perda de dados (data breach) sobre as conversas dos usuários e as informações relativas ao pagamento dos clientes do serviço de assinatura. Após as primeiras notificações sobre o problema, a OpenAI interrompeu brevemente o serviço e reconheceu uma falha em uma ferramenta externa, que afetou 1,2% dos assinantes e um número indefinido de usuários gratuitos. Não foram só os italianos que voltaram a colocar a IA em pauta. A União Europeia (UE) ficou diante de uma encruzilhada em seu esforço de regular o uso da ferramenta, já que deve criar uma forma de proteger os usuários de uma tecnologia em constante mudança.

A UE está preparando um projeto de lei para regulamentar a inteligência artificial, que pode ficar pronto até o final de 2023, ou início de 2024, e ser aplicado em alguns anos. A Comissão Europeia, o braço executivo do bloco, anunciou em abril de 2021, pela primeira vez, um plano para um conjunto de regras de IA. O Parlamento Europeu espera finalizar um projeto neste mês. A China, por sua vez, também se posicionou a respeito e pretende adotar uma “avaliação de segurança” para as ferramentas de IA, no momento em que grandes empresas de tecnologia do país tentam desenvolver instrumentos simulares ao ChatGPT. Os chineses querem regulamentar a chamada inteligência artificial generativa. Antes da comercialização dos produtos que utilizam esta tecnologia – Baidu, conhecido por sua ferramenta de busca, foi uma das primeiras empresas chinesas a estabelecer uma presença na IA, seguida por Tencent (internet e jogos eletrônicos) e Alibaba (comércio eletrônico) – será necessário passar por uma “inspeção de segurança”, de acordo com um projeto de regulamentação divulgado nesta semana pela Administração do Ciberespaço da China. Contudo, ainda não há uma data para norma entrar em vigor.

A capacidade dessa nova geração de inteligência artificial tem assustado a população mundial, tanto pelas oportunidades que se abrem quanto, principalmente, por seus riscos. Os especialistas, no entanto, dizem que estão longe de identificar todas as possibilidades da IA. Um exemplo do problema que pode ser originado pela inteligência artificial é o episódio ocorrido com o analista de transporte Randal Quran Reid. O americano foi preso por um crime que não cometeu. De acordo com os advogados da vítima, a prisão ocorreu após falha em um reconhecimento facial com inteligência artificial, usado por uma delegacia. Reid foi acusado por roubo no município de Nova Orleans, em Louisiana, onde nunca havia estado e ficou uma semana preso. A polícia não esclareceu o motivo, mas depois de soltá-lo disse que a prisão do analista de transporte foi “infeliz”. Para especialistas, a depender do modo como essas ferramentas são disponibilizadas e utilizadas, o impacto da IA generativa pode ter diferentes contornos. O equilíbrio desses efeitos depende do estabelecimento de padrões éticos e de uma regulação, o que não houve, por exemplo, com as redes sociais. A empresa Clearview, por exemplo, reuniu milhares de fotos da internet pública, incluindo sites de mídia social para criar um mecanismo de busca baseado em rostos, que agora é usado por agências governamentais. Inclusive, no caso de Reid, ele tem várias fotos publicadas na web vinculadas ao seu nome, como no Linkedin e no Facebook.

IA precisa ser detida?

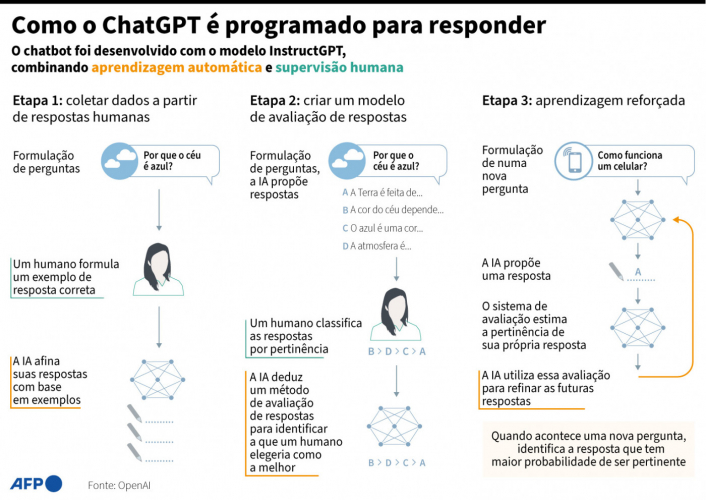

Os especialistas dizem que não, até porque essa tecnologia é importante para o dia a dia, como aponta o professor de Sistema de Informação da ESPM e especialista em Arquitetura de Software, Carlos Rafael, em entrevista ao site da Jovem Pan. “Hoje a sociedade se beneficia muito da IA, pois sem ela nós não conseguiríamos fazer relatórios, propagandas mais assertivas, analisar dados, entre outras coisas. Dependemos da IA. Porém, o fácil acesso a ela precisa ser usado com bom senso”, diz o docente, que aponta as mudanças no cenário atual, já que antes apenas cientistas de dados conseguiam usar. O especialista afirma que essa massificação da IA apresenta três grandes perigos para humanidade. O primeiro risco são para as pessoas leigas. “O ser humano sofre da inércia. A partir do momento que você pergunta algo para IA, ela responde e um especialista válida aquela informação, após a terceira vez que fez isso e o processo deu certo, você para de validar as informações e passa a usar sem saber o que está utilizando, podendo estar reproduzindo informações falsas”. Rafael usa como referência o chatGPT. O segundo principal problema é o vazamento de dados. “A IA não é ensinada por uma professora e não tem tempo para aprender, ela faz tudo de forma rápida. Os cientistas pegam uma base de dados que acham confiáveis e pedem para o robê ler e começar ‘aprender’, e é aqui que mora o perigo, porque a IA é boa em replicar o que ela aprende, o que pode ocasionar em vazamentos de dados, como na Itália”. O terceiro fator que merece atenção é o desemprego em massa. “A partir do momento que uma empresa descobre que ao invés de 10 funcionários ela pode ter um, vai começar a demitir os colaboradores”, acrescenta.

Eduaro Tomasevicius FIlho, professor da Faculdade de Direito da USP, pontua que a IA, em si, não é perigosa, mas depende da sua aplicação. “Há uma visão holywodiana sobre a IA, que ela pode controlar os humanos e destruir planetas, mas não é bem assim porque ela não é um ser vivo, ela só funciona se tiver energia”, explica, defendendo que a tecnologia traz mais benefícios que malefícios. Contudo, Rafael chama atenção sobre o que significa “controlar os humanos”, porque ela pode ser interpretada de duas formas. “A partir do momento que dependo IA, então ela já dominou”, resume. Márcio Lopes de Freitas Filho é advogado, sócio-fundador do escritório Martins Cardozo Advogados Associados, e foi assessor especial do Ministério da Justiça, onde colaborou nos processos de elaboração do Marco Civil da Internet e da Lei Geral de Proteção de Dados Pessoais. À reportagem, ele explicou que a “inteligência artificial surge como uma ferramenta a serviço dos seres humanos, mas existe o risco de que ela passe a ser uma entidade que passe a usar os humanos como ferramenta para seus propósitos, seja por falta de limites em sua programação, seja por alguma intenção maliciosa do programador ou do operador da IA”. Ele complementa dizendo que não existem modelos testados no mundo real para a regulamentação e controle desses riscos.

É exatamente isso que levou à produção de uma carta nos últimos dias sobre o tema, pedindo uma pausa no desenvolvimento e evolução dos sistemas de IA, porém, ele não acredita que o documento tenha o poder de ” frear o desenvolvimento dessas novas tecnologias para uma prévia avaliação de riscos e de custo-benefício”. Além dos riscos apontados, a tecnologia está cada vez mais autônoma e perfeccionista. Ela consegue desenhar mãos realistas e aumenta o perigo da desinformação. Antes, a tecnologia criava fotos de mãos inchadas com dedos a mais ou pulsos esticados, indicando nitidamente que eram falsas. Isso porque os dados usados capturavam apenas pedações das mãos. No entanto, em março, o Midjourney, um conhecido criador de imagens, lançou uma atualização de software que corrigiu as falhas. Mas a tecnologia, em pouco tempo, foi usada para desinformação: foram produzidas imagens do ex-presidente Donald Trump sendo preso e do papa Francisco com estilo mais ‘descolado’. Ambos os conteúdos foram publicado nas redes sociais e viralizaram. No caso do ex-presidente dos EUA, a publicação foi feita após o republicano ser indiciado pela Justiça de Manhattan por um caso de pagamento de suborno a uma atriz pornô e ter se tornado o primeiro ex-mandatário na história do país a responder formalmente por um crime.

AI-generated image of Pope Francis goes viral on social media. pic.twitter.com/ebfLK4F850

— Pop Base (@PopBase) March 25, 2023

Com base nesses fatos, uma carta foi divulgada no fim de março pedindo uma pausa no desenvolvimento de novas gerações de inteligência artificial. O documento foi assinado por executivos do setor, como o bilionário Elon Musk, dono do Twitter, e por mais de mil acadêmicos, como o historiador Yuval Harari. “Nos últimos meses, vimos laboratórios de IA se lançarem em uma corrida descontrolada para desenvolver e implantar cérebros digitais cada vez mais poderosos que ninguém, nem mesmo seus criadores, pode entender, prever, ou controlar com segurança”, diz um trecho da carta. “Devemos permitir que as máquinas inundem nossos canais de informação com propaganda e mentiras? Devemos automatizar todos os trabalhos, incluindo os gratificantes? (…) Devemos nos arriscar a perder o controle da nossa civilização? Essas decisões não devem ser delegadas a líderes tecnológicos não eleitos”, conclui. Musk e os especialistas ainda disseram que a IA irá causar uma “dramática perturbação econômica e política (especialmente para a democracia)”. O diretor da Open AI, que criou o ChatGPT, Sam Altman, reconheceu ter “um pouco de medo” de que sua criação seja usada para “desinformação em larga escala, ou para ciberataques”. “A empresa precisa de tempo para se adaptar”, comentou recentemente à emissora ABCNews. Entretanto, na sexta-feira, 14, confirmou que sua empresa por enquanto não desenvolverá o GPT-5, suposto sucessor de seu chatbot de inteligência artificial GPT-4. Apesar do apelo feito por Musk, o Twitter desenvolve um projeto de IA. O bilionário teria comprado milhares de processadores potentes e caros e contratado especialistas em engenharia de inteligência artificial, informou o portal Insider. O Information, outro site especializado em tecnologia, afirmou que o empresário cogita a ideia de criar um concorrente para o ChatGPT.

Regulamentação da IA

Apesar de alguns países saírem à frente em relação a regulamentação da IA, ainda não nada definitivo em cima disso. “Não tem lei que limite a IA, ainda esta tendo um processo. No Brasil está parada. Apesar de existir desde 2020, não avançou no que estava encaminhado”, diz Eduaro Tomasevicius Filho, acrescentando que mesmo que não tenha uma legislação, se ocorrem danos, “não significa que as pessoas vão ficar sem indenização porque se aplicam as regras gerais do direito, porque pouco importa a causa do dano, existe ali ele deve ser reparado”. Rubens Leite, advogado e sócio-gestor da RGL Advogados, explica que no Brasil existe uma autoridade nacional de proteção de dados, órgão responsável por fiscalizar e regulamentar está área. “Não temos um regramento que limita o uso da IA em si, o que temos são arcabouço jurídico, direito penal, civil, intelectual, temos legislações que limitam até onde a IA pode ir, mas seu uso é totalmente permitido”, explica, alertando que “tem legislações que possuem vedações para uma série de atos que a IA pode cometer por meio da empresa. E elas são de responsabilidade da organização que está por trás da IA e do usuário que faz uso indevido dessa ferramenta”.

Márcio Lopes de Freitas Filho, acrescenta que no Brasil a própria LGPD, em seu art. 20, fala do direito de qualquer pessoa de questionar quaisquer decisões tomadas com base em tratamento automatizado de dados em relação a si. “Esse dispositivo foi pensado já para sistemas mais rudimentares de classificação de perfis e escore de risco financeiro, mas são plenamente aplicáveis por decisões tomadas por inteligência artificial”, porém, ele destaca que “falta, contudo, bastante transparência tanto pelas empresas quanto pelo próprio governo em relação ao que está sendo feito de forma automatizada e como está sendo a supervisão humana sobre isso”. E enquanto isso ficar apenas na mão de desenvolvedores e fora de mecanismos de controle público, sem qualquer regulamentação ou accountability, estaremos aumentando os riscos de abusos e violações que possam ser cometidos com o auxílio de inteligências artificiais. “É preciso que o debate saia do campo de programadores e especialistas em computação e abranja mais setores da sociedade. Se não sabemos qual o melhor modelo de regulamentação, o mínimo que devemos exigir é que o uso dessas tecnologias e qualquer processo que tente regulá-las seja transparente e público”, finaliza.

Midia NAS

Midia NAS