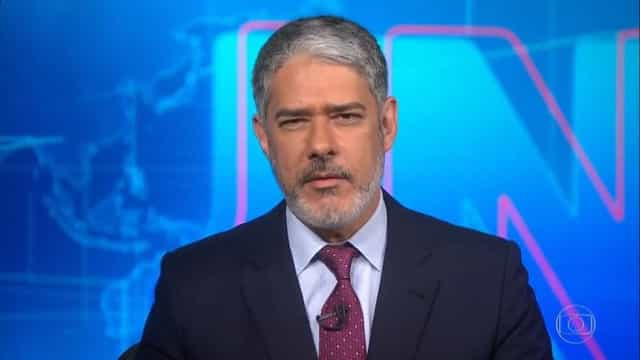

Vídeo falso de Bonner expõe falhas de big techs contra fake news perto da eleição

Na semana passada, cinco dias após a data em que o vídeo começou a ser compartilhado com mais intensidade nas redes sociais, o conteúdo falso seguia disponível nas principais plataformas.

As empresas só removeram ou sinalizaram com alertas os links que traziam a imagem e a voz do apresentador do Jornal Nacional adulterados depois do contato feito pela reportagem da Folha de S.Paulo.

Os acordos de combate à desinformação firmados com as principais big techs pelo TSE (Tribunal Superior Eleitoral) foram propagandeados por ambos os lados nos últimos meses. Eles não foram baseados em obrigações para a retirada de conteúdo, mas passaram a prever a disponibilização de um canal facilitado do tribunal com as companhias para envio de denúncias de posts suspeitos.

Cada plataforma possui regras e critérios distintos para moderação daquilo que é compartilhado por seus usuários. Assim, na reta final da eleição, ganha importância a rapidez com que as redes detectam violações às suas diretrizes e aplicam as respectivas punições para evitar viralizações de mentiras.

Só há obrigatoriedade de remoção quando há decisão judicial -antes, a iniciativa é das próprias big techs.

No caso do vídeo falso de Bonner, o pior cenário detectado foi nas plataformas de vídeos curtos TikTok e Kwai, em que diferentes posts atingiram mais de 100 mil visualizações. Vídeos compartilhados em diferentes redes tinham a marca d'água de ambas, o que indica que foram baixados desses aplicativos.

Além de terem algoritmos elaborados para potencializar a distribuição de conteúdos virais mesmo de usuários com poucos seguidores, essas redes fomentam a viralização multiplataforma, já que facilitam o download do vídeo ou seu compartilhamento na íntegra diretamente no WhatsApp -app no qual a moderação é inexistente- e no Telegram, cuja forma de atuação é pouco conhecida.

No TikTok, o vídeo de um perfil com 5.000 seguidores somava mais de 299 mil visualizações na sexta (23). Outro vídeo, de um usuário com pouco menos de 2.000 seguidores, chegou a 185 mil visualizações.

Ambos foram removidos, enquadrados como "desinformação prejudicial". Em nota, a rede disse levar "extremamente a sério a responsabilidade em proteger a integridade da plataforma e das eleições".

No Kwai, uma busca no aplicativo permitiu encontrar dezenas de vídeos falsos. A Folha enviou alguns exemplos para a empresa, que respondeu que "manipulação audiovisual" viola suas diretrizes e que "os conteúdos e suas duplicações foram removidos". Diversos posts, contudo, continuavam na plataforma.

Um deles havia atingido mais de 138 mil acessos até segunda (26). Em nova resposta, a empresa afirmou que eles "deverão ser derrubados" e que estava fazendo uma "varredura para remover os duplicados".

"O mesmo vídeo passa por diversas plataformas", diz Maria Paula Almada, do Instituto Nacional de Ciência e Tecnologia em Democracia Digital e diretora do Aláfia Lab. "Esse controle é muito complicado."

No Facebook, no Twitter e no YouTube, as publicações que ainda estavam disponíveis até sexta-feira não tinham viralizado. Não é possível saber o número de postagens que envolveram o conteúdo falso em cada uma das plataformas e se as publicações foram alvo de moderação rapidamente.

No Facebook, a maioria dos vídeos encontrados pela reportagem levava o rótulo de "vídeo adulterado" e links que desmentiam seu conteúdo. Após contato da Folha, posts sem as marcações foram rotulados.

No Twitter, foram anexadas às publicações, classificadas de "mídia manipulada", links de "saiba mais". A plataforma diz que denúncias de usuários ajudam "a identificar novas narrativas falsas" e a alimentar seus sistemas de detecção proativa. Já o YouTube removeu os vídeos e disse que "coibir desinformação e teorias da conspiração prejudiciais é um desafio, porque o conteúdo está sempre mudando e evoluindo".

Para realizar a moderação, as plataformas combinam inteligência artificial e trabalho humano. Falta, porém, transparência sobre o investimento nessas áreas para o idioma português. Pequenas alterações, como a inclusão de uma legenda, podem dificultar a detecção automatizada de um mesmo conteúdo.

O TSE não analisa se os conteúdos enviados por usuários e encaminhados pelo canal de denúncias ferem as diretrizes das plataformas, tampouco se sofreram algum tipo de moderação. Tampouco há um estudo amplo sobre como as redes estão -ou não- aplicando suas próprias regras no contexto desta eleição.

Tal monitoramento é complexo, porque há muitos dados aos quais só as empresas têm acesso e porque a interpretação do que viola uma política pode variar, dadas as formulações por vezes bastante genéricas.

Apesar disso, estudos têm identificado falhas e inconsistências, como o experimento da organização internacional Global Witness, que submeteu para aprovação do Facebook anúncios que diziam, falsamente, que a data da eleição havia mudado. Esse conteúdo não foi detectado pela plataforma.

No caso do YouTube, monitoramento da Novelo Data destaca a falta de homogeneidade na moderação. "O YouTube define algumas regras e tem um comportamento de não executar muito bem essas regras", diz Guilherme Felitti, sócio da consultoria. "Não é difícil encontrar vídeos que são infrações flagrantes."

Um exemplo recente foi a exclusão de vídeos segundo os quais uma perita teria concluído que a voz em um áudio sugerindo "acabar com o Palocci" seria do ex-presidente Luiz Inácio Lula da Silva (PT), líder das pesquisas na corrida ao Planalto e principal adversário da campanha à reeleição de Jair Bolsonaro (PL).

Primeiro, o conteúdo foi removido de um canal com cerca de 3.000 inscritos. Mas o vídeo só foi removido de um canal com mais de 1 milhão de inscritos no dia seguinte e de um outro com 400 mil seguidores depois de cinco dias, entre outros perfis de menor relevância.

Em nota, a empresa afirma que as regras "não levam em conta o tamanho do canal ou sua notoriedade e as diretrizes são aplicadas de maneira independente, de acordo com o sistema de alertas".

Midia NAS

Midia NAS